LATEST ARTICLES

Dimensity 6300: MediaTek lanza su nuevo SoC móvil de gama media

El fabricante taiwanés nos trae su nuevo procesador móvil. Se trata del MediaTek Dimensity 6300. Es un SoC de gama media. Viene a conformar la evolución del anterior Dimensity 6100+. MediaTek Dimensity 6300 El chipset está construido en una arquitectura de 64 bits. Lo fabrica TSMC en 6 nanómetros (nm). Consta de un total de 8 núcleos organizados en dos clústeres....

Google reorganiza sus equipos de software y hardware y crea su división “Platforms and Devices”

La inteligencia artificial (IA) está a la orden del día. Requiere y demanda urgencia para las empresas. Google fue, es y será una de las afectadas y motivadas. Ello es el origen y justificación de su nueva reorganización. Sundar Pichai, CEO de la marca, ha sido quien dio el anuncio. El año pasado el punto de partida fue la unión...

Ear y Ear (a) son los nuevos auriculares de Nothing

La marca lo había anticipado y ahora lo hizo oficial. Nothing revela sus nuevos auriculares Ear y Ear (a). Con esta nueva nomenclatura, quiere dejar de lado los números. O quizás lo destinen para otros productos, como sus smartphones: Phone (2). En auriculares parece que irán por las letras. Volvamos a dichos audífonos. Los dos son MUY parecidos, tanto por...

¿Renaper sufrió nuevo hackeo masivo? Esto es lo que se sabe hasta el momento

En las últimas horas -- o par de días -- han saltado las alarmas. El Registro Nacional de las Personas (Renaper), organismo dependiente del Ministerio del Interior de Argentina, habría sufrido una brecha de seguridad. O quizás más de una. El panorama es poco claro y demasiado confuso. Ante esto, nos vemos en la necesidad de tratar de recapitular la...

Cómo funciona el plan canje de Motorola

Hice la experiencia de canjear un teléfono viejo por uno nuevo más la diferencia en el programa de Canje de Motorola. ¿Valió la pena? ¿Me dieron lo suficiente por el teléfono viejo? Cambié un Moto One Hyper por un flamante Moto G14 y aquí les muestro cómo fue la experiencia paso a paso. No es un video esponsoreado, aclaro, pagué mi propio...

Adiós Atlas, hola nuevo Atlas

Boston Dynamics, ahora una empresa de Hyundai, le dice adiós a su "viejo" robot Atlas para presentarnos uno totalmente nuevo 100% eléctrico. ¿es que el otro no lo era? Pues no, gran parte del movimiento elástico lo hacía con pistones hidráulicos, esta nueva versión, mejorada, apunta no sólo a utilizar sólo servos eléctricos sino que ya tiene en miras la...

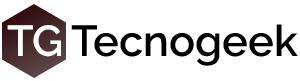

Encontrado el segundo agujero negro más grande de la Vía Láctea

Los agujeros negros se clasifican en dos categorías principales: los supermasivos que se encuentran en los centros de las galaxias y los de masa estelar formados a partir de supernovas de estrellas muy masivas. Antes de los detectores de ondas gravitacionales, los agujeros negros estelares más masivos conocidos tenían alrededor de una docena de veces la masa del Sol....

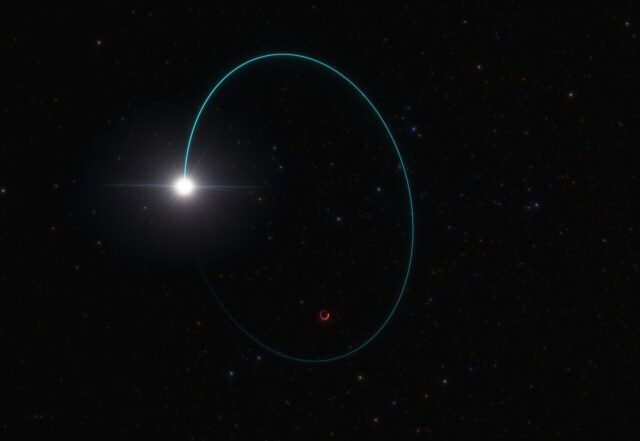

Intel anuncia Gaudi 3 para competir contra NVidia en AI

Intel sabe que hay un mercado gigante del cual no puede perder la oportunidad y Gaudi 3 sería su procesador para tratar de arrañar un poco del negocio de NVidia. Durante los últimos meses NVidia creció y se revaluó de una forma increíble gracias a sus GPU orientados a servidores y AI, si blockchain y esas cosas quedaron en el...

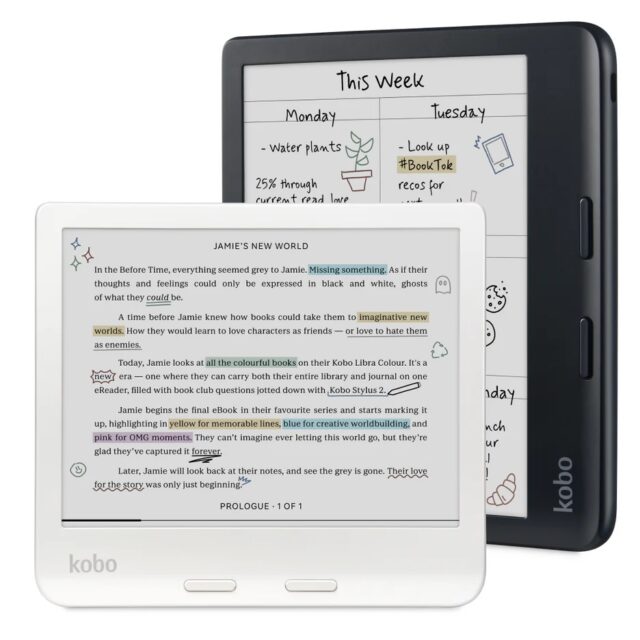

Kobo le da color a sus e-readers

Admito que soy muy fan de los ereaders por sus pantallas de e-ink, pero más aun fantaseo con pantallas color como las que Kobo trae ahora! A partir del 30 de abril podremos adquirir la Kobo Clara Colour por unos USD 149.99 o la Kobo Libra Colour por USD 219.99, similares a sus predecesoras blanco y negro, pero a color! La...

Olvídate de la obsolescencia programada: Fairbuds, los audífonos sostenibles que te durarán años

¿Cansado de auriculares que se rompen o cuyas baterías mueren después de un año? Fairphone, la marca de smartphones sostenibles, entra al mundo del sonido con los Fairbuds, unos audífonos inalámbricos que rompen el molde. Olvídate de comprar un set completo porque se te perdió un auricular. Con Fairbuds, puedes reemplazar solo la pieza que necesites. ¿La batería te está...