La semana pasada les presentamos cómo era el procesador de la PS4 por dentro y hoy le llega el turno al SoC de la XBox One que tiene algunas notables diferencias con su “hermano” rival.

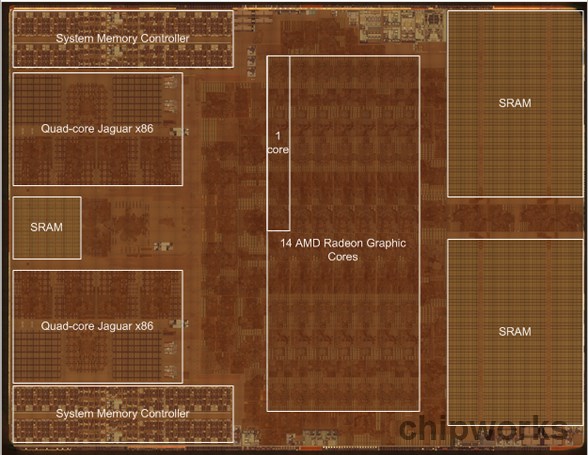

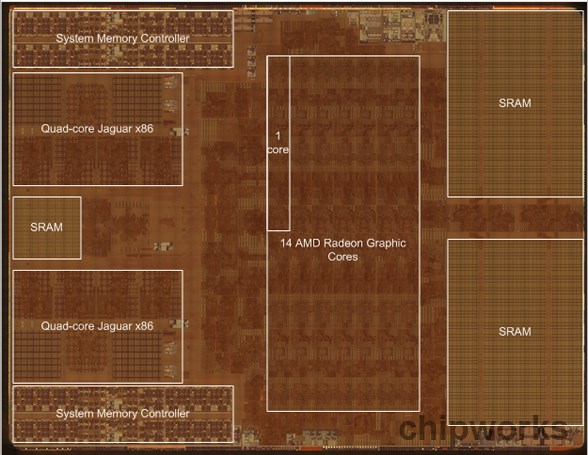

Una vez más la gente de ChipWorks realizó un exahustivo análisis con rayos X del APU o SOC, como quieran llamarlo, de la consola de Microsoft revelando porqué tiene menos CPU aun siendo un 5% más grande con 363 mm2.

El sector dedicado al GPU compromete 14 Compute Units Radeon (12 disponibles) en vez de 20 de la PS4 (18 disponibles), esto implica un 30% menos de potencia gráfica directa pero he aquí que la adición de 47MB de SRAM dentro del core cambia el escenario completamente.

Recordemos que Microsoft decidió utilizar memoria RAM tradicional, DDR3, para abaratar costos en la consola, en cambio Sony optó por la más cara GDDR5, esta SRAM dividida en tres bloques le permite tener una latencia mucho menor para lo importante y remitirse a la RAM cuando hace falta, ahora bien, la realidad habrá que verla en benchmarks que son casi imposible de producir sin una apertura total de los SDK a los reviewers.

Los CPUs son los mismos cores Jaguar x86 de AMD que tiene la PS4, así que en ese sentido van por el mismo camino, ocho núcleos en dos bancos de cuatro cada uno.

Más allá de eso es notable cómo no les quedó lugar para más CPU ni GPU al incorporar esta memoria, desde el lado de la performance no se puede predecir mucho, la XBox One será más rápida para encontrar algo en memoria mientras la PS4 podrá mantener mayor cantidad de datos fluyendo a mayor velocidad, ¿cual enfoque es el óptimo? considerando que muchos developers crearán juegos para ambas plataformas es difícil saberlo todavía.

Fabio te copio unos mensajes q lei de un tipo q parece q la tiene bastante clara, a ver q te parece.

32MB de eSRAM son un Parche. Es de hehco un ScratchPAD, es decir un conjunto de memoria que aunque está en este caso embebido en la APU (Procesador que unifica en un mismo chip CPU y GPU), es decir que no es una memoría chaché que coloca y registra la colocación de los datos automaticamente por parte de los procesadores, sino que esa llamada, depositado, envio, registro de localización, etc, tiene que ser llavado por los desarrolladores por Software, en cada programa (juego). Y eso es un COÑAZO.

Ademas los 200GBps de ancho de Banda son teoricos, la realidad y admitida por los propios diseñadores del hardware en una entrevista es que esa memoria de media REAL solo llega a 140/150GBps de Ancho de Banda.

Pero lo importante realmente es que hablamos de solo 32MB de eSRAM. Y esos 32MB de eSRAM tienen que estar continuamente recibiendo datos desde los 8GB de RAM DDR3 por anticipado y en cantidad para poder dar de comer los datos que demanda la GPU. Pero a su vez tiene que estar tambien grabando los resultados de operaciones datos de pasos intermedios (hasta la fabricación de un fotograma o durante varios fotogramas), que produce la GPU. Y por descontado y tambien hacer de Buffer (conjunto de memoria separado virtualmente y reservado para almacenar una información concreta puede ser una información final de salida con todos los pixeles que forman un fotograma o un buffer de sombras, en el que se almacenan los datos para aplicar las sombras de cada objeto en funcion del punto de vista del observador y de la geometría del escenario del juego, y las luces presentes en el mismo, etc, etc), a la vez que hace todo lo anterior. Y hablamos de 32 míseros escasos y tristes MegaBYTES, para hacer todo ese trabajo, y que todo ese trabajo tiene que hacerlo cada programados en concreto. Es decir que desarrollar para que el juego simplemente vaya bien es un Descojostio.

Por otro lado están los requermientos del juego. Un Juego si nos ponemos en lo más básico de lo básico tiene, Geometría y Texturas. Dicho eso hay que hacerse a la idea de que una textura no es mas que una foto que se pone sobre una geometría, adaptada a su forma. Si quieres mejores texturas necesitas fotos de mejor calidad, digamos (por poner esto simple y no andar con los infinitos tipos de formatos de texturas que hay ya). El problema es que si quieres Texturas de calidad, las fotos tienen que ser de calidad y eso supone unos archivos de imagen que pesan en conjunto no mucho, sino muchísmo, y mas si no quieres perder tiempo de proceso con sistemas de compresión importante.

Conclusión: pues que resulta que te puedes encontrar con que en un juego actual entre escenas de video pregrabadas y texturas son el 70/80% del espacio del Disco. Es decir si un juego actual ocupa unos 30/40GB, pues las texturas facilmente se puede llevar mas de 10/15/20GB despues de descomprimir. Creo que con eso queda claro que las texturas son archivos GRANDES. ¿Cuanto peso en datos pueden supone las texturas en un fotrograma para un juego actual?

Depende de como lo midas. Pero siendo directos MUCHO MUCHO MAS QUE 32MB de eSRAM.

Bien que algun genio venga aquí ahora y me cuente como esos 32MB de eSRAM salvadores lo puede hacer para llevar los datos de geometría, texturas, para alimentar la GPU, y tambien y por descontado los Buffers que use la GPU a la vez para ir colocando datos entre procesos …

Os respondo NO DA. Y sobre todo no da de sí pero ni de coña en cuanto se ponen los desarrolladores a usar Renderizado en Diferido (sistema de renderizado/dibujado que a diferencia del Forward Render, consiste en separar la escena a dibujar se descompone en fases/pases o partes, por ejemplo un pase de sombras, otro para las transparencias, etc, etc y en el que los datos resultantes de calcular esas fases se almacenan en memoria hasta que están todos completados y se puede crear el forograma acabado), y meter 4,5,6 o más Buffers de imagen a resoluciones 1080p (1920×1080 lineas), con una calidad de 16bits por pixel. NO ENTRA, es que NO ENTRA. Y actualmente casi todos los Engines (Motores de REnder de los juegos), actuales usan tanto Forward Render como Deferred Render (Renderizado Diferido), a la vez para segun que cosas o momentos.

¿Que hacer si no entra todo?

Lo mas sencillo —> Bajas la resolución. Menos pixeles menos información a tratar.

Asi de claro. No hay mas historias.

Por tanto esto que estamos viendo en los juegos de XBOX One, el que salgan con menos resolución que los de PS4, no es algo puntual.

Es que va a ser la tónica y casi que la norma en muchos muchos juegos, ahora y a medio plazo, quizá incluso a largo.

¿Porque?

Porque la GPU de XBOX One es hasta un 50/56% peor que la de PS4, y porque su arquitectura de memoria es una MIERDA.

Y como de mierda es la GPU de de XBOX One:

La GPu de XBOX One:

– Es una GPU AMD: arquitectura GCN, 12 CUs (Compute Units), 750 Stream Processors, 32 Texture Units, 2 ACEs & 16 Registros, 853Mhz, 1,3 TFlops (calculos en coma flotante por segundo). De esos 1,3 TFlops hay que restar un 10% que se reserva en todo momento Kinect, por lo que digamos que quedan 1,1TFlops para juegos.

PS4:

– GPU AMD, arquitectura GCN, 18 CUs (Compute Units), 1152 Stream Processors, 78 Texture Units, 8 ACEs & 64 Registros, 800Mhz, 1,84 TFlops. Todo para los juegos.

Por otra parte además el que vea una mejor CPU en XBOX One, pues sí pero no.

Y aqui si me lo permitís me voy a citar a mi mismo en una respuest a otra persona por aqui en xataka, que decía que no veía diferencias entre 1080p y 720p, y que la diferncia entre sistemas no era para tanto, o el manido tema del catalogo inicial, y futuro.

Y para no tener que volver a escribir lo mismo pues pongo aquí lo que puse, ayer que completa lo que he dicho arriba aunque hay alguna parte que repito. La cita en cuestión:

<<<"Voy a ser directo a nivel de GPU (procesador encargado de tratar todo el apartado gráfico) PS4 es entre un 50% y un 56% mas capaz que XBOX One. Hablamos de que en un caso es una GPU con 1,3TFlops, 12CUs [Compute Units] 752 Stream Processors –>(XBOX One), y a esos 1,3TFlops hay que restarles un 10% de tiempo de proceso de esa GPU que son para Kinect por tanto hablamos de 1,1TFlops para juegos. En el caso de PS4 hablamos de una GPU con (1,84TFlops, capacidad de cálculo en Coma Flotante), con 18 CUs, y 1152 Stream Processors.

Para llevar una comparación a donde y qué serían esas GPUs en PC diriamos que es como si XBOX One equipara una hipotetica AMD ATi Radeo 7770/7780 (la serie 77xx de AMD es la GAMA BAJA), y PS4 equipara una hipotetica AMD ATi Radeon 7860.

A parte y para mas inri en el caso de la GPU de PS4 hablamos que incorpora 8 ACEs (Asynchronous COmpute Engine), con 64 registros en total. Mientras que XBOX One, monta 2 ACEs y 16registos.

¿Y para que vale esto de los ACEs?

Para que la GPU mediante el uso de lenguajes y librerías tipo GPGPU (hablo de CUDA de Nvida o OpenCL), pueda realizar trabajos que hasta ahora realizaba la CPU habitualmente, y hacerlo ademas mucho mejor y mas rápido. Gracias a ese mayor numero de registros y de ACEs, en PS4, los programadores pueden jugar mucho mejor (hasta un 400% mejor en PS4 con respecto a XBOX One), con los tiempos en que ciertas partes de la GPU están ociosas a la hora de "fabricar" un fotograma, para hacerlas trabajar en aspectos como la IA, Fisicas, etc, etc.

Porque si de algo pecan las dos consolas es de tener CPUs muy escasas.

Y ya que estamos me permito hablar de la comparación de frecuencias entre las CPUs de PS4 y XBOX One. Porque hay una Diferencia de 100/150Mhz aprox entre ellas a favor de XBOX One.

Y el que eso sea así viene de que cuando se produjo la presentación de la XBOX One en Mayo, y en la que MicroSoft trató de vender la XBOX One, como un nuevo centro de ocio mas que como una consola y acompañó esa presentación con la confirmación de con unas politicas DRACONIANAS, que obligaban a conectar una vez al día la consola a internet o sino es que no podías jugar, y que prohibían la segunda mano, y etc, etc, (que luego tuvo que quitar y hacer por tanto la mayor bajada de pantalones que este mundillo ha visto porque no le quedaba otra). Pues tambien salieron a la luz las especificaciones oficiales de la consola, que por otra parte confirmaron lo que las filtraciones de Enero/Febrero decían. Y entre esas politicas y esas especificaciones les empezó a llover tal cantidad de MIERDA, -y con razón-, que en vista del éxito y viendo que su GPU se quedaba muy por detrás de la de PS4, pues a útlima hora hicieron un OverClock (subir las frecuencias de trabajo de los MicroProcesadores para ganar algo mas de fuelle), que les permitía el hardware estando como estaban a 5/6 meses de lanzamiento. Y subieron 53Mhz la GPU (que pasó de 1,2 TFLops a 1,3 TFlops), y para mantener el Sincronismo con la CPU pues subió tambien de 1,6Ghz a 1,7Ghz.

Para que hayan considerado y hecho una subida como esa, (un 7 y 9%, lo que supone 1 o 2fps más apenas), que es muy poco y aumenta como todo OverClock el riesgo de tener problemas de sobrecalentamiento con el tiempo,y teniendo como tiene MicroSoft los antecedentes que tiene a ese respecto con XBOX 360, pues imaginaos como de MAL tiene que haber visto y de hecho sigue viendo MicroSoft el percal a nivel de hadware y a nivel técnico con respecto a PS4.

Por cierto teniendo como tiene PS4 más ACEs y registros y un 50/56% mas de capacidad de proceso, pues usando GPGPU para apoyar a la CPU, el suponer que a nivel de calculo tipo CPU XBOX One supera a PS4 por correr a 100Mhz más es no tener NI IDEA de que van estos temas. Es como decir que un Core2DUO es mejor en prestaciones y rendimiento que un Core i7 Haswell, porque el Core2DUO corre a 2,8GHz, y el Corei7

Es como decir que un Core2DUO es mejor en prestaciones y rendimiento que un Core i7 Haswell, porque el Core2DUO corre a 2,8GHz, y el Corei7 a 2,6GHz … , es decir una gilipollez.

En cuanto a la arquitectura de la memoria, pues no sé ni por donde empezar. Lo que MicroSoft tenía claro es que quería un Sistema Opeartivo con Kinect y Multitarea. Y para que un sistema operativo pudiera hacer todo lo que ellos querían y bien, pues eso les obligó a tener que meter mucha memoria RAM, y como se les disparaba ya el precio por la MIERDA de Kinect pues verse obligados a meter una memoria con un precio barato pero con unas prestaciones de MIERDA para una GPU como es la memoria DDR3. En concreto en XBOX One, hablamos de un conjunto de 8GB de memoria principal de tipo DDR3, y que a día de hoy no montan ni las GPUs de gama mas baja. ¿Porque no la usan las GPUs ni de gama mas baja? Porque tiene un Ancho de Banda muy bajo (68GBps de Ancho de Banda en el caso de la de XBOX One a repartir entre CPU y GPU). Que para una CPU es suficiente, pero para una GPU actual la catidad de Ancho de Banda que hace falta es mucho mayor. Para parchear eso le han metido un ScratchPad de 32MB de eSRAM (que de media consigue los 140/150GBps de Ancho de banda), pero que siendo como son, apenas 32MB en muchos casos se quedan y repito muy pero que muy cortos.

Este tema de la memoria y el 50/56% menos de GPU es lo que hace que los juegos de XBOX One, estén saliendo con menor resolucion que en PS4.

Ya que PS4 por su parte monta un único Conjunto Central de memoria de 8GB de memoria GDDR5 (con una Ancho de banda sostenido de 176GBps)

Es decir que PS4 tiene mejor GPU CLARAMENTE, y mejor arquitectura de memoria.

Guste o no guste, y venga quien venga. Son hechos.

Dicho todo esto, dices que no te importa la Resolución. Y que no ves la diferencia entre 720p y 1080p. Para empezar busca Oftalmologo, y no digo oculista que conste, sino un Médico Oftalmologo porque lo tuyo ya parece grave.

Pero por si realmente es que no las ves y no tienes problemas medicos, te lo pongo de otra manera:

Digamos que hay un juego en XBOX One corre a 720p de resolucion. Y tenemos el mismo juego corriendo exactamente a la misma resolucion, en PS4. Bien pues dicho juego en PS4 podría tener entre un 50 y un 56% mas de cosas en pantalla que en el de XBOX One.

Es decir a igualdad de resolucion y de FrameRate en un juego cualquiera, los desarrolladores tienen, asi como quien no quiere la cosa, un 50/56% más de GPU de la que tirar para poner en pantalla mejores fisicas, IA, Filtros, Efectos, PostProcesado, Animaciones, etc, etc, etc … , en PS4 con respecto a lo que veas en XBOX One.

Así que quizá la Resolucion te importará un huevo … . Pero si el aspecto gráfico de los juegos, mas allá de la resolución, no te importa, te recomiendo algo: comprate como consola una NES de Nintendo que tiene (y no va de broma) de los mejores juegos que ha habido mas allás de los graficos y ademas seguro que la encuentras y no te cuesta 500€.

Y en cuanto al catalogo de salida. El que se compra una consola solo por su catalogo de salida, es como alguno que juzga una casa por la fachada. Es decir mas corto de miras que un ministro.

Y en cuanto a catalogo de exclusivos y quien trata mejor en ese aspecto a largo plazo al usuario, el que tenga dudas que pierda un poco de tiempo y mire las exclusivas que ha recibido XBOX 360 este 2013 y las que ha recibido y está recibiendo PS3.">><<

Y por cierto XBOX One, NO SOPORTA MANTLE.

MANTLE es una API gráfica como puede serlo DirectX de MicroSoft o OpenGL (Open Graphic Library) administrado por Khronos Group.

PS4 tiene su propia API Gráfica basada en OpenGL llamada LibGCM (si mal no recuerdo).

XBOX One tiene su propia versión de DirectX.

Y en cuanto a MANTLE es una API gráfica que ha presentado AMD hace unos meses que se supone que es mucho mejor que DirectX y que OpenGL ya que evita los problemas que tienen estas otras APIs. El problema de DirectX es que es muy encorsetado y muy lento, las llamadas de datos a memoria pasan por tantos pasos que es muy poco eficiente, y además al ser propiedad de MicroSoft los desarrolladores apenas puede tocar nada. En cambio OpenGL es libre lo puedes tocar como y cuanto, quieras y es mucho mas eficientes pero al ser libre con el paso de los años, se ha llenado de muchas cosas aportadas por mucha gente y de formas diferentes y hace que sea complicado ponerte a sacarle partido a dicha librería.

Con la intenciónde de tener una API que sea eficiente, modificable y sencilla y libre de morralla antigua, para el PC, nace MANTLE.

Pero si estais al tanto de estos temas, la semana pasada fue la AMD Developers Summit en San José California, donde varios ponentes hablaron sobre el uso de la tecnología AMD. Habló por ejemplo el Vicepresidente de Sony Computer Entertainment de Investigación y Desarrollo y confirmó que PS4 soporta la última tecnología presentada por AMD para el Audio llamada TrueAUDIO con DSPs (Procesadores Digitales de Señal) de Tensilica mas integración y reparto de cálculo del sonido entre ellos, la GPU y la CPU, por Software para conseguir mejores efectos y tratamiento del sonido.

Y en ese ciclo de conferencias , -y sí ya voy al grano-, DICE Studios de EA, presentó su Engine de Renderizado FrostBite 3, que es uno de los abanderados del uso de MANTLE, comentaron que de haber similitudes entre MANTLE y otra API es con la API de PS4.

Y era obvio. ¿Porqué?. Porque ambas APIS están basadas en OpenGL. Mientras que la API de XBOX One, es 100% derivado de Direct3D/DirectX.

¿Y eso que quiere decir?

Pues que juegos que sean desarrolldos con la API MANTLE, puede ser adaptados mucho mas fácil y rápido a PS4 que a XBOX One, y teoricaente seguir disfrutando de las ventajas que tiene dicha API.

Pero repito ni PS4 soporta MANTLE como tal (pero es mucho mas facil que los desarrolladores que han programado su juego en MANTLE lo lleven a la librería de PS4), ni XBOX One tampoco, de hecho mucho mucho menos, son de hecho practicamente contrarias.

—-000—–

Conclusión por mi parte:

Si os gustan las sagas de MicroSoft u os vuelve loco alguna de sus sagas exclusivas sin la que no podeis vivir, compraos la XBOX One. No hay problema.

Ahora las cosas claras y el chocolate espeso, en lo que se refiere al Hardware para JUGAR, PS4 lleva como poco un 50% de ventaja.

Allá despues cada uno en como invierte su dinero.

Lo que está claro tambien es que ambas consolas en cuanto capacidad gráfica estan ya lejos de lo que hay en PC, (con GPUs de 4 TFlops), por lo que no es que lleven un Hardware de la leche ni mucho menos.

Ahora en cuanto a relación prestaciones/precio para jugar, PS4 se lleva la comparación con XBOX One, de calle.

Salu2

Hasta ahi termina, es bastante extenso, pero me parece interesante. Espero tus comentarios, a ver q piensas al respecto, tuve q partirlo por q en un solo mensaje no entraba

wall of text innecesario y con ciertas cosas tiradas de los pelos, pero tiene razon

esperemos por gabe al rescate