Bueno, hoy empezó Google I/O, el evento para developers de Google, Android y todas las apps y frameworks que acompañan el enorme universo que conforman al gigante Googlero y en este posteo les voy a dejar las primeras impresiones de lo que se viene tanto para Android, Google Assistant, Gmail y más.

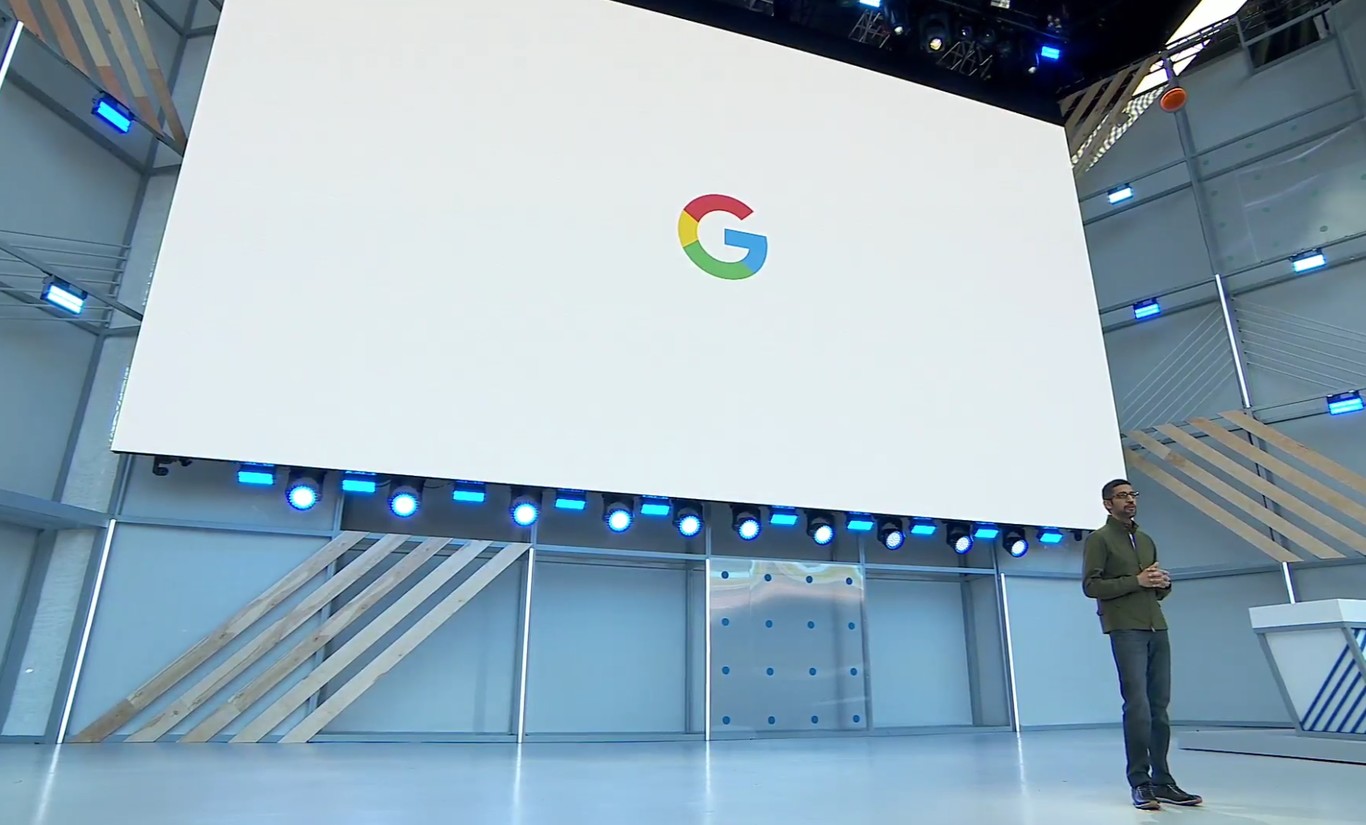

IA para Gmail

Ya sabemos que Google lee todos nuestros emails desde el primer día en que usamos Gmail, pero más allá de publicidad hay otra función que se puede aplicar a esto: entender qué y cómo.

Imaginen entonces que Gmail responda tus mails automáticamente, esos rutinarios u obvios, que agregue en agenda cosas obvias ya lo hacía, desde pasajes a citas, pero esto es un paso más allá y para eso, una vez más, todo el Machine Learning encima.

Será como un autosuggest (el nombre es Smart Compose) pero bastante más completo y consistente, obviamente no espero verlo tan despabilado en español, hace rato que no le tengo fe a ninguno de los esfuerzos de ML para el lenguaje cuando se trata de algo que no sea inglés.

Otro detalle será la colorización de imagenes, no tiene mucho que ver con todo esto pero es un ejemplo de lo útil que puede ser Machine Learning bien utilizado (si, les gusta llamarlo Inteligencia Artificial pero siendo correctos, no lo es).

Más info aquí

Google News

Otro uso del Machine Learning será la renovación de Google News. Esto me gustaría verlo en acción porque no confío en absoluto en ningún algoritmo censurador/ajustador de las noticias que leemos. El caso ejemplo es el timeline de Facebook y lo poco relevante que termina siendo. Si me guío por lo mal que andaba el de Google Now sugiriéndome noticias “porque te interesó X tema” y las fuentes de dudosísima calidad que utilizaba… Pero tengámosle fe por un momento.

Google viene insistiendo con la idea de que mejor una máquina para curar contenidos, con respecto a las noticias habrá que ver si esto respeta algún tipo de pluralidad o si tiene que ver con nuestros deseos reales, algo que casi toda red social siempre intenta forzar con horribles resultados. Es que el interés de los humanos a veces dura poco tiempo o varía de cosa en cosa, aun para las noticias.

Más info aquí

Android P

La futura versión de Android sigue avanzando y ya está disponible la beta, hay muchas mejoras como es de esperar especialmente implementando muchas APIs para Machine Learning por lo que los devs para apps podrán acceder a muchos servicios más si es que se les ocurre cómo aprovecharlos. Google Asistant será el obvio primer aprovechador de esto y tendrá mucha más relevancia en Android P.

Interesante es que Google se rinda al usuario un poco, dándole un poco de contro, sumando el Google Dashboard para controlar tiempos de uso, permisos, info relevante, App Timer para regular el tiempo de uso y limitarlo, Wind Down para bajar el tono a escala de grises para cuando tu cerebro demanda paz, etc.

Gestures emulando a Palm y a iOS reduciendo la barra inferior, estimo que varios odiarán este cambio por la “costumbre”, nadie quiere cambiar sus costumbres.

Por el momento los modelos compatibles son:

- Pixel

- Pixel XL

- Pixel 2

- Pixel 2 XL

- Essential Phone

- Nokia 7 plus

- Oppo R15 Pro

- Sony Xperia XZ2

- Vivo X21UD

- Vivo X21

- Xiaomi Mi Mix 2S

Más info aquí

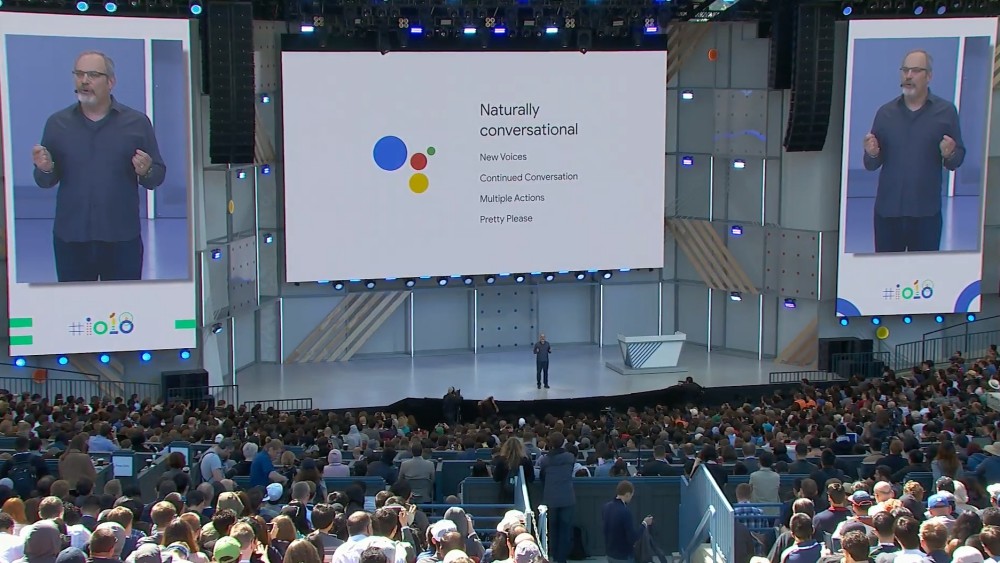

Google Assistant

El asistente de Google, que tiene como directos competidores a Siri, Alexa y Cortana, evoluciona bastante en esta presentación con nuevas voces con seis nuevos tonos/voces creadas por ML para variar un poco, conversación contínua (si, como se imaginarán, la del ida y vuelta natural), combinar acciones, es decir, preguntar más de una cosa de una sola vez (aquí hacen agua todos), etc.

La idea es extenderlo a otras apps como, por ejemplo, desde Google Maps que uno pueda, mientras está manejando, enviar mensajes y demás sin que interrumpa la navegación ni que el usuario tenga que sacar la mirada de la calle. Esto es tal vez uno de los temas peor manejados por todos, ¿Lo hará bien? Obvio que algún día así será, esperemos ver cómo lo implementan.

Ahora bien, suma algo extraño e interesante que es que Assitant hable por vos para ciertas llamadas, así es, por ejemplo realizar una reserva o algo por el estilo. Google Duplex es la característica nueva y recién empieza la beta este año. La idea es que vos le pidas a Assitant algo, si hay un servicio online para conseguirlo (sea API o sitio web) lo hará automáticamente, si no, hará una llamada con lo que estás pidiendo.

Es muuuuuy loco si logran implementarlo bien y habrá que ver cómo interactúa con humanos reales del otro lado de la línea porque si es para pedir pizzas a donde yo pido les juro que jamás se entenderán ni hablar cuando te ponen en espera diez minutos porque estan levantando otros pedidos 😀

Más info aquí