Seamos sinceros, nadie jamás usa Grok, primero porque hay que tener una cuenta paga de Twitter/X, segundo porque existen alternativas mucho más interesantes, funcionales, efectivas y sin un Elon Musk diciendo estupideces por detrás.

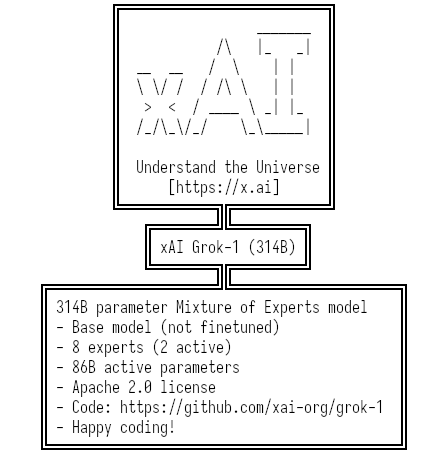

Pero, como sucede con los modelos de LLM que no son tan buenos, si no es perfecto mejor liberarlo, así que han publicado un torrent de 296GB del modelo entrenado con unos 314 billones de parámetros.

¿300GB? ¿Es posible usarlo en alguna PC? Obviamente no, es un modelo gigante como lo es ChatGPT, para ello se necesitan varios GPU de los grandes en paralelo, así que son muy pocos los que podrán probarlo “localmente”, aunque no creo que lo hagan demasiados debido a su tamaño y poca imporancia.

Quienes seguro lo tomarán primero son los científicos que hacen benchmarks de modelo de AI para poder, ahora sí, compararlo de forma independiente y sin el ruido de su dueño.

¿A favor? Sí, tiene licencia Apache 2 que es un avance enorme con respecto a prácticamente todos los modelos “abiertos” y permite su uso libre, los pesos son de 8 bits.

Si uno quisiera correrlo en una PC necesitaría unas 6-7 placas RTX 3090 considerando una inferencia de 3 o 4 bits, cargar los 8 bits ya pasa a otro nivel.

Si uno quisiera correrlo en una PC necesitaría unas 6-7 placas RTX 3090 considerando una inferencia de 3 o 4 bits, cargar los 8 bits ya pasa a otro nivel.

La performance es muy baja considerando la cantidad de parámetros que tiene, pero ya los expertos dirán si es que hace falta refinar algo o qué, lo cierto es que por ahora no cambiará nada en el mercado de Inteligencia Artificial. La realidad es, como dije anteriormente, uno libera no el mejor modelo, sino el peor 😋

Pueden encontrar todo en Github