Nvidia es conocida por ser la líder en Inteligencia Artificial, mantener eso requiere lanzamientos como el del Blackwell, una arquitectura especialmente dedicada a AI para superar a su ya existosa serie H100/H200/GH200.

Hopper da paso a Blackwell, el nombre es en honor al matemático Dr. David Harold Blackwell, el primero en escribir un libro sobre estadísticas bayesianas, y el segmento al que apunta es obviamente servidores: este no es un GPU para tu workstation.

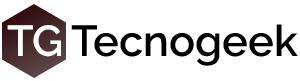

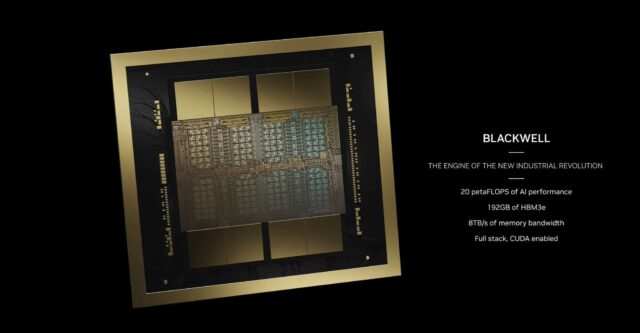

Blackwell viene en dos versiones, B100 y B200, siendo el B200 un sistema de dos GPU conectados por NVLink 5 con un ancho de banda de 1800GB/sec.

Doble GPU implica doble memoria, dos bloques de 96GB de VRAM HBM3E para un total de 192GB, un ancho de banda de memoria de 8TB/sec y doble bus de memoria de 4096 bits.

Doble GPU implica doble memoria, dos bloques de 96GB de VRAM HBM3E para un total de 192GB, un ancho de banda de memoria de 8TB/sec y doble bus de memoria de 4096 bits.

Obviamente no será algo que caliente poco, el TDP anunciado es de 1000W, superior a los 700W del H100, el proceso de fabricación es de TSMC 4NP, un poco más moderno que el 4N de la generación anterior. Esto tal vez le quite un poco de ventajas al B200 con respecto al H100, no será un nodo de 3nm que brindaría, además, la ventaja de poder poner más transistores en menor espacio.

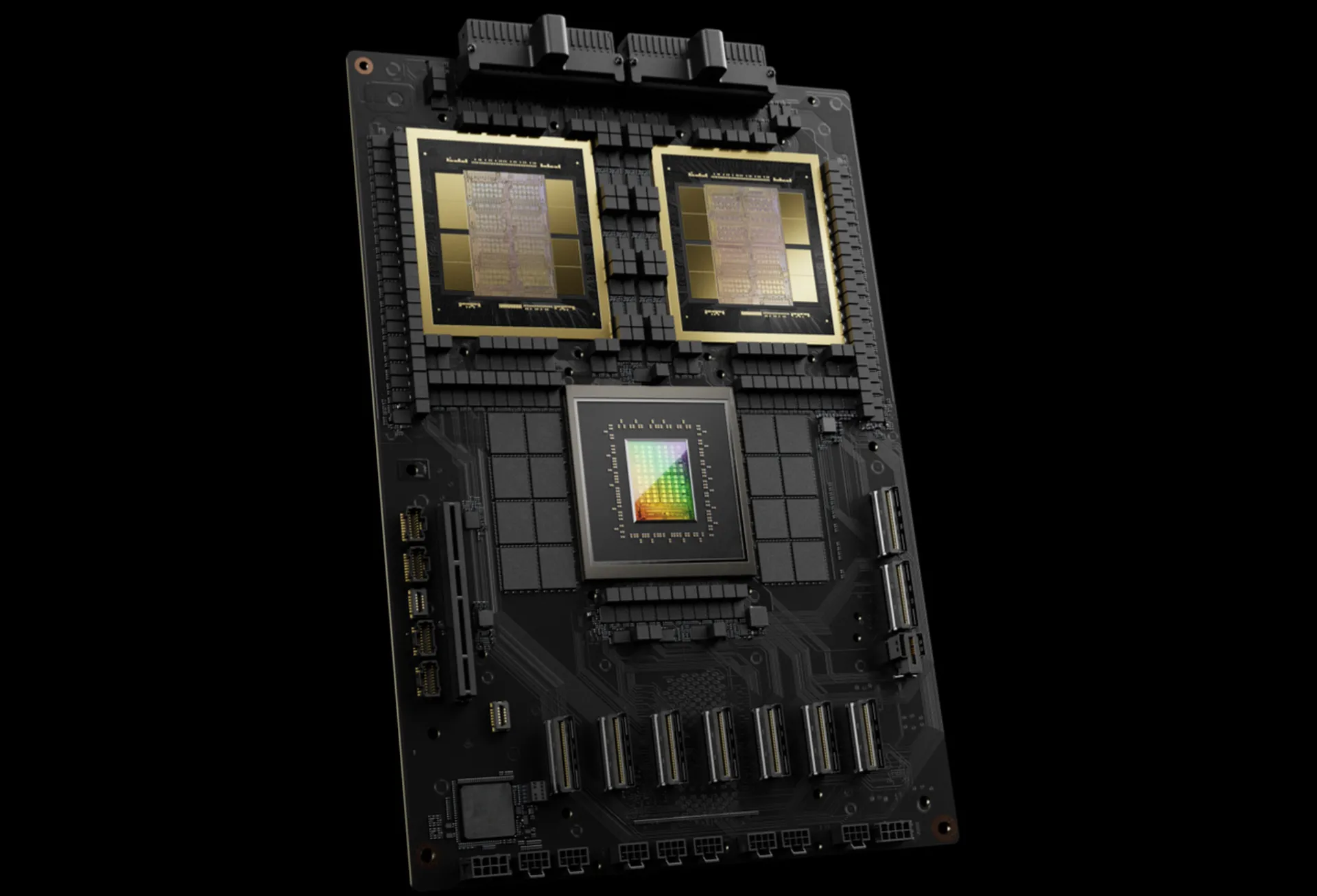

La performance será de 20 PetaFLOPS para FP8 (punto flotante de 8 bits), 20PFLOPS ara FP6 y 40PFLOPS para FP4 que es la “novedad” en este procesador.

El chip cuenta con una cantidad bestial de transistores, 208.000 millones, lo que puede ofrecer mejoras de hasta 25X en consumo con respecto al H100 y, dependiendo de qué se quiera hacer, hasta 7 veces más performance.

El chip cuenta con una cantidad bestial de transistores, 208.000 millones, lo que puede ofrecer mejoras de hasta 25X en consumo con respecto al H100 y, dependiendo de qué se quiera hacer, hasta 7 veces más performance.

El NVLink 5 permite conectar de a 576 GPUs entre sí en una red de 1.8 terabytes por segundo bidireccionales.

Cada chip está emparejado con cuatro stacks de memoria HBM3E, los 192GB de VRAM son importantes porque es el cuello de botella más común en el entrenamiento de modelos.

La mejora de performance en general es modesta, un promedio de 14%, lo que cambia radicalmente es la densidad por bloque de cómputo, achicando la cantidad de nodos para obtener el mismo resultado, cuando logren llevar esto a 3nm o 2nm ahí veremos una diferencia sustancial.

La discusión sobre los tensors y la precisión es para otro ambiente más detallado, algunos critican que basen las mejoras en FP4 cuando todo se entrena en FP8 o FP16, según NVidia no hay una pérdida sustancial de precisión usando FP8 así que empuja hacia abajo para abaratar el coste de la memoria.

Y si sos gamer y esperás ver algo de esto alguna vez, es altamente probable que la arquitectura Blackwell sea la misma base para la generación 50 de las RTX.