Se que ponerme a hablar de computación cuántica es un chino para la mayoría, es que lo es!, pero no hay dudas de que en un futuro muy cercano cierta porción de la informática pasará por esta rama totalmente distinta y extraña del cálculo.

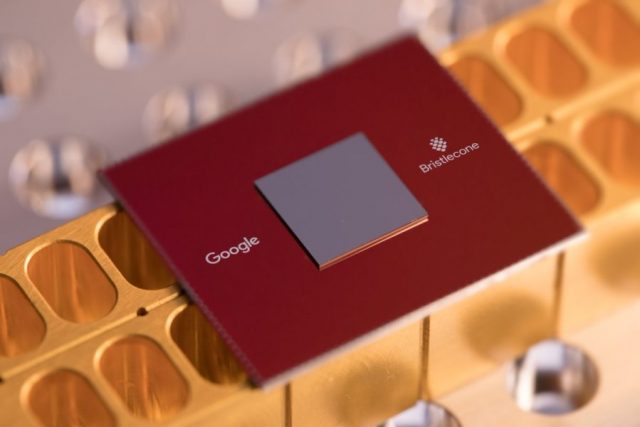

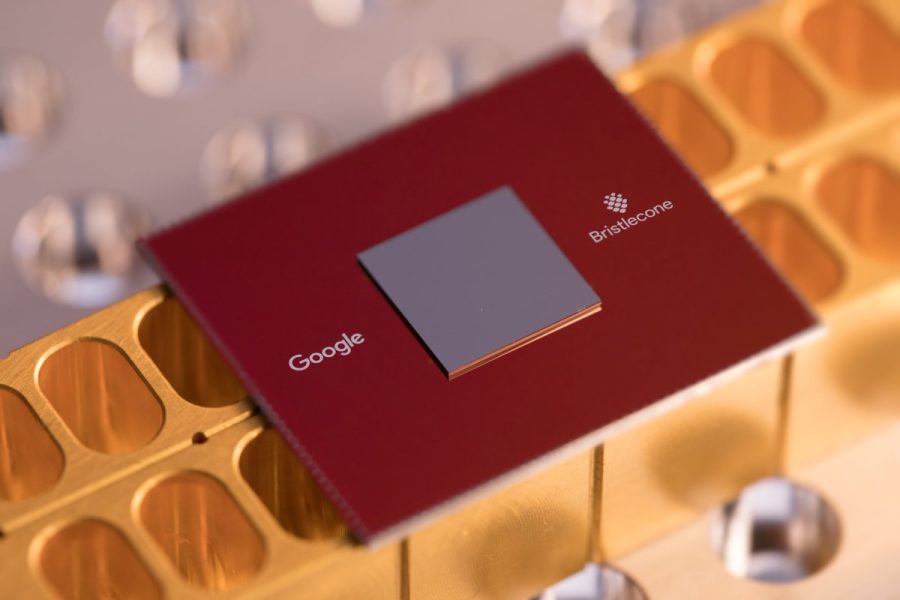

El problema con los procesadores cuánticos es que en la medida que se escala su tamaño también lo hace su probabilidad de error, bajar esto último implica llegar a lo que se conoce como la “Supremacía Cuántica”, es decir, cuando los procesadores cuánticos son superiores a los electrónicos no sólo en velocidad sino confiabilidad.

El tema del error es normal en esta área, la supremacía cuántica se alcanza a partir de 49-56 Qubits (podríamos compararlos con los bits en un procesador aunque no es tan así, pero para darles un contexto, son bits cuánticos con la posibilidad de estar polarizados vertical y horizontalmente al mismo tiempo) y un 0.5% de error cada dos qubits, con esto ya se podría superar a una supercomputadora en ciertos cálculos (no sirven para todos).

Según Google su nuevo precesador “Bristlecone” no sólo tiene 72 qubits sino que además su margen de error es 1% total, 0.1% por un qubit, 0.6% por dos qubits, en teoría logrando la supremacía tan esperada ya que las más grandes supercomputadoras actuales pueden simular el comportamiento de hasta 46 qubits.

Por ejemplo, para simular un equipo con 72 qubits sería necesario más RAM de la que pueden imaginar (2^(72-46)), así que ya de por sí se estaría por delante de cualquier bestial equipo actual.

El objetivo es mantenerse por debajo del 1% de error en un sistema de 100 qubits para empezar a resolver problemas del mundo real, en unos años será posible alcanzar algunos miles de qubits y por ende destruir cualquier sistema de encripción actual. Se vienen tiempos interesantes.

Via Tom’s Hardware