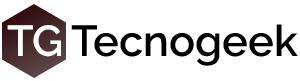

Es una movida muy particular pero con un objetivo, en un CPU integrar el GPU tiene limitaciones especialmente en el ancho de banda, por ejemplo AMD está por integrar en su futura generación el controlador de memoria GDDR5 directamente en el mismo, en el caso de Intel estan buscando competir de alguna forma con las soluciones móviles de NVidia, al menos en el segmento medio.

Por lo general se soluciona el problema del ancho de banda de memoria con mayores velocidades (por ende mayor consumo) o interfaces más anchas (mayor superficie de silicio), ambas soluciones son un inconveniente en el mundo móvil y de bajo consumo, si uno mantiene en un mismo silicio el CPU y el GPU hay que solucionarlo de otra forma para que la relación entre ambos y la memoria no sea un cuello de botella como sucede con los GPU de Intel actualmente.

Intel ya había rechazado la idea de integrar memoria en el SoC, es que resulta inconvenientemente caro para el chip, salvo que lleguemos a este punto de tantos núcleos necesitándolo. La idea del Haswell GT3e es competir más o menos con una GeForce GT650M, estar a la altura.

Si bien faltan los detalles técnicos confirmados por Intel se especula con unos 128Mb de eDRAM dentro del silicio con proceso de fabricación de 22nm, Tri Gate, MIMCAP COB y un bus de 512bits.

El ancho de banda que permitiría sería de 64Gb/s que no es lo más grande que hay en soluciones high-end pero a nivel de GPUs de Intel sería un aumento significativo, en un proceso de 22nm el tamaño extra sería de unos 60mm2 y podría ser utilizado como caché L4, por lo que lo podría aprovechar un servidor y el CPU, no solamente el GPU.

El costo extendido sería de unos USD50 por procesador y se fabricará sólo como BGA, es decir, para ser soldado, no para conectar en un socket, así que evidentemente apunta a notebooks y ultrabooks, nada de desktop donde los GPU discretos tienen mayor aceptación porque… hay lugar!

Intel no tiene el historial ni de Nvidia ni AMD en el tema de GPUs pero poco a poco estan dedicándole esfuerzo y dedicación, no estarán a la altura pero sus soluciones se estan volviendo más populares entre los fabricantes por el costo reducido al no tener que integrar más circuitos al motherboard, pero… la performance está muy por debajo de sus rivales, en soluciones high-end siempre le ganan por un amplio margen, esto seguramente contribuirá a achicar esa diferencia.

Via Anandtech

Esta claro que las eDRAM son mejores que las SRAM y DRAM pero en definitiva solo complican las tareas. Son mas lentos que los caches. Es el mismo caso de las APUs Y Shaders Unificados. Las frankenstein APUs NO brindan un rendimiento como una CPU y un GPU independientes. También frankenstein SHADERS UNIFICADOS NO brindan rendimiento como VERTEX SHADERS Y PIXEL SHADERS INDEPENDIENTES….. Es cierto las APUs y los shaders Unificados reducen costos y proceso pero; a cambio EL AJUSTE Y SACRIFICIO cuando se trata de tarea en 3D lo tenemos presente en RELENTARIZACIONES.

CONCLUSION un eDRAM es un truco por un cuello de botella.